Micronは、データセンターおよびAIアクセラレータ向けの最新メモリである「HBM3E」メモリの量産を開始したと発表した。同社のHBM3E known good stack dies(KGSD)は、2024年第2四半期に出荷される人工知能(AI)およびハイパフォーマンス・コンピューティング(HPC)アプリケーション向けのNVIDIAのH200 compute GPUに使用される。

これまでのHBM3と比較して、HBM3Eはデータ転送速度とピークメモリ帯域幅が44%も向上しており、データ転送速度9.2GT/秒、ピークメモリ帯域幅1.2TB/秒超を誇る。これは、NVIDIAのH200のような帯域幅を必要とするプロセッサにとって特に重要である。

NVIDIAのH200は、Hopperアーキテクチャに基づいており、コンピューティング性能自体はH100と同等だ。だが一方で、最大4.8TB/秒の帯域幅を特徴とする141GBのHBM3Eメモリを搭載しており、H100の場合の80GBのHBM3と最大3.35TB/秒の帯域幅から大幅にアップグレードされている。

加えてMicronは、自社のHBM3Eメモリは、競合他社であるSamsungやSK hynixよりも消費電力が30%低いと主張している。

しかし、SamsungのShinebolt HBM3Eメモリの定格は1.225TB/秒であるため、Micronは最速のHBM3Eを実現したとは言えないようだ。

HBM3Eは、チップあたりの最大容量36GBを実現するが、NVIDIAのH200向けHBM3Eは24GBとなり、HBM3の最大容量と同等だ。また、HBM3Eが理論的に提供できる最大12ではなく、8ハイスタックをサポートする。

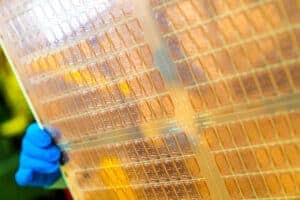

MicronはHBM3Eの製造に同社の1β(1ベータ)プロセス技術を使用しており、データセンターグレードの製品に最新の製造ノードを使用している同社にとっては、製造技術の高さを示す重要な成果である。

競合のSK hynixやSamsungに先駆けてHBM3Eメモリの量産を開始したことは、現在HBM分野で10%の市場シェアを持つMicronにとって大きな成果である。この動きは同社にとって極めて重要である。というのも、Micronがライバルよりも早くプレミアム製品を投入することで、より大きな市場シェアを獲得しながら収益と利益率を向上させる可能性があるからだ。

Micronのエグゼクティブ・バイス・プレジデント兼チーフ・ビジネス・オフィサーであるSumit Sadana氏は、次のように述べている。「Micronは、業界をリードするHBM3EおよびHBM4のロードマップ、ならびにAIアプリケーション向けのDRAMおよびNANDソリューションの全ポートフォリオを通じて、今後のAIの大幅な成長をサポートする体制を整えています」。

Micronはまた、3月に開催されるNVIDIAのGTCカンファレンスで、同社の36GB HBM3Eチップの詳細を発表する予定だと述べている。同社によると、36GBのHBM3Eチップは1.2TB/秒以上の帯域幅を持ち、電力効率が向上し、スタッキングの上限が12チップになるという。この36GBモジュールのサンプリングも3月に開始される。

Source

コメントを残す